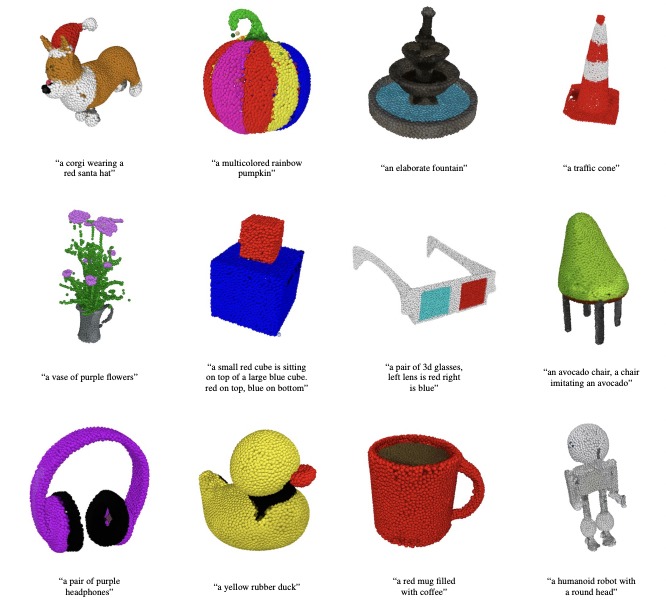

OpenAIから画像やテキストが3DポイントクラウドにしてくれるPoint-EがGitHubにて公開されました。特徴と現状どのようなことができるのか見ていきましょう!

Point-Eの特徴

Point-Eは1つのGPUで1~2分程度で3Dオブジェクトを生成します。論文によると、まずテキストから画像への拡散モデルを用いて1つの合成ビューを生成し、次に3D点群を生成する仕組みです。この仕組みを活用したのがPoint-Eです。

セットアップ方法

Point-EはPythonを利用しているので、PythonがPCに入っている必要があります。

さらに、ExampleのファイルはJupyter Notebookのフォーマットで書かれているのでこの辺の環境の準備が必要です。

私はM1 Macを使っているので、この辺りの情報が大変役に立ちました。

図解!Jupyter Notebookを徹底解説!(インストール・使い方・起動・終了方法)

環境が整ったら、READMEをよく読みます。とは言ってもやることはクローンしてきたディレクトリで下記のコマンドを打つだけです。

pip install -e .Examplesの実行方法

Jupyter Notebookを起動します。私はコマンドからインストールしたので、コマンドを入力して起動をしました。

jupyter notebookコマンドを入力するとブラウザでJupyter Notebookが起動します。なのでGUI上から起動したいExamplesを選択して、Runで実行します。

image2pointcloud.ipynb ⇨ 合成画像からポイントクラウドを抽出します。

text2pointcloud.ipynb ⇨ テキストから3Dへのモデルを使用して、テキスト記述から直接3D点群を生成する。機能は限られていますが、いくつかの簡単なカテゴリと色がわかります。

pointcloud2mesh.ipynb ⇨ 点群からメッシュを生成するためのSDF回帰モデル

もう少し手軽に試してみたい人向け

Mirageというサービスで画像とテキストから3DモデルがGUI上から生成できます。最終的にobjなどでダウンロードができますので、圧倒的に手軽に試せます。

ログインすると50クレジットが付与されて、一回に2クレジット消化されるようです。

まとめ

まだまだ精度はこれからという感じですが、精度が粗くても手軽に何かを表現するのに使えそうだなーという印象を持ちました。あっという間にWebサービス化されていて、Webの速度を改めて感じました!

コメント